Por Andrés Mayo

En el mundo del audio profesional, como en casi todos los demás, la tecnología nos empuja diariamente a superar nuestros propios estándares de calidad. Una de las demostraciones de esto es el interés de muchos fabricantes por producir equipamiento capaz de trabajar con frecuencias de muestreo cada vez más altas. Partiendo de los “módicos” 44.1 KHz del CD y de los 48 KHz que fueron el standard para video durante años, hoy en día la mayoría de las producciones profesionales tienen al menos alguna etapa realizada en un sample rate superior: 88.2, 96, 176.4, 192, 352.8 y 384 KHz.

Pero es interesante analizar si detrás de esta nueva “carrera armamentista” en pos de frecuencias de operación cada vez más altas existe un fundamento técnico real que lo justifique. Veamos los hechos:

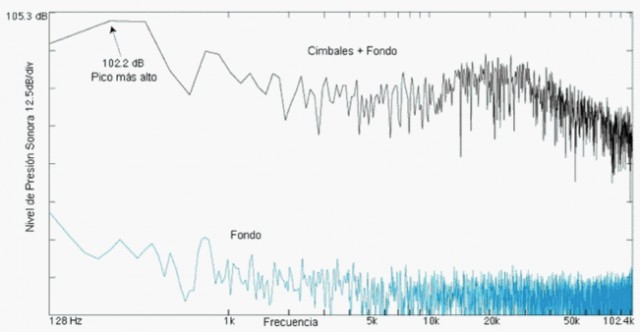

1) Al menos un miembro de cada familia de instrumentos musicales (percusión, cuerdas, metales y maderas) produce energía mensurable hasta los 40 KHz como mínimo, y en algunos casos mucho más altas aún. Ejemplos: la trompeta, el violin y el oboe mantienen su energía hasta los 80 KHz y el cimbal (o crash) hasta los 100 KHz, de acuerdo con un estudio realizado durante la década pasada en el California Institute of Technology (ver imagen 1).

2) Ciertamente el oído humano no alcanza a percibir la presencia de información en tales rangos de frecuencia, sin embargo (de acuerdo a la mayoría de los especialistas a nivel mundial) estas señales intermodulan con las señales que sí somos capaces de oir, modificándolas de diferentes maneras. Ya en 1991 un equipo de investigadores japoneses liderado por el notable Tsutomu Oohashi presentaba a la AES los resultados de su trabajo. Midiendo la actividad eléctrica producida en el cerebro humano a partir de la estimulación producida por sonidos de muy alta frecuencia, los investigadores llegaron a la conclusión de que éstos inducían la activación de “ritmos de electroencefalograma” que persistían aún en la ausencia de esta estimulación y que podían modificar la percepción de la calidad de sonido.

3) En un entorno típico de grabación musical, las intermodulaciones de HF (alta frecuencia) no llegan a reproducirse a través de los parlantes porque son limitadas por la máxima frecuencia muestreable por el sistema. Como sabemos, en un medio digital operando a 44.1 KHz la máxima frecuencia de audio permitida es de 22.05 kHz, de acuerdo con el Teorema de Nyquist. Frecuencias mayores a Fmuestreo / 2 que ingresen o se generen dentro del sistema producirán el efecto de aliasing y serán eliminadas por el siguiente filtro pasabajos.

Podemos concluir entonces que estas intermodulaciones de HF que en algunos casos consideramos importantes para la completa reproducción de la identidad sonora de ciertos instrumentos, no serán incluidas en el espectro sonoro de un sistema de audio profesional cuya máxima frecuencia de muestreo sea de 48 KHz.

Figura 1: (Amplitud vs Frecuencia) La figura representa una toma de cimbales, a 108.3 dB hecha con micrófonos B&K 4135, aproximadamente a cuarenta y cinco centímetros de distancia. El trazo superior indica los cimbales + fondo (background), corregido hacia 100 kHz. El trazo inferior solo el fondo. Nótese que la energía en 20, 30 y 40 KHz es mayor a la de 2, 3 y 4 KHz respectivamente; y que a 100 kHz se mantiene todavía muy por encima del background. Medición realizada por el Ing. James Boyk, del California Institute of Technology. Copyright 1992-1997 James Boyk.

Pero sin ninguna duda, un sampling rate más alto no garantiza de por sí mayor calidad de audio. Eso es parte del mito hi-tech que intenta vendernos la tecnología más cara con argumentos difíciles de comprobar. Es similar a la leyenda “Calidad CD” que traían muchos reproductores de audio de distintos formatos, como el MP3. ¿Qué significa calidad CD? Es obvio que el CD puede sonar tan bien o tan mal como se haya procesado el audio que está contenido dentro de él. En formas similares, los vendedores de equipamiento de audio profesional intentarán convencernos de que un equipo con capacidad de trabajar a una frecuencia de muestreo más alta es necesariamente mejor que uno que no posee tal capacidad. Esta parte de la historia es parcialmente cierta, por las razones expuestas anteriormente: en determinados casos (por ejemplo, la grabación de una batería en un entorno acústicamente controlado, utilizando micrófonos de alta performance para los cuerpos de la batería y overheads) pude comprobar personalmente la diferencia de trabajar a 48 KHz y luego a 96 KHz. Habiendo realizado las pruebas en idénticas condiciones y escuchando detenidamente en un entorno altamente controlado, encontré ligeras diferencias en la resolución de alta frecuencia,que se hacían más identificables en los micrófonos de platillos y de overheads. Mi conclusión al cabo de esta experimentación sonora fue que la modulación producida por la inclusión de señal de muy alta frecuencia afectaba la manera en que se percibía la información que sí se encontraba dentro del espectro audible. Por decirlo de otra manera, en mi escucha comparativa encontré diferencias debidas principalmente a la interacción entre las frecuencias audibles y las frecuencias inaudibles, que de esta manera pasaron a ser perceptibles. Si la información muestreada a 96 KHz se hiciera pasar a través de un filtro pasaaltos capaz de cortar en 48 KHza 24 dB/octava sin dudas dejaríamos de percibir por completo la señal resultante, porque al no haber intermodulación con frecuencias del espectro audible no seríamos capaces de registrar la presencia de señal de tan alta frecuencia.

Pero volviendo a los argumentos comerciales para sostener la venta de equipamiento caro, sepamos que de ninguna manera la frecuencia de muestreo nos garantiza calidad, en ninguna etapa de la grabación de audio.

Un elemento fundamental en este proceso es lo que conocemos como downsampling, es decir la etapa en la cual la señal muestreada debe ser reducida a su frecuencia de muestreo final (por ejemplo 44.1 KHz en el caso del CD). Este procedimiento es complejo y puede traer aparejada una degradación importante, que anularía todo el esfuerzo puesto en captar los mínimos detalles de resolución durante la etapa de grabación. Las técnicas de downsampling más comunes utilizan algoritmos específicos para convertir una señal discreta muestreada a una frecuencia FS in en otra señal muestreada a FS out. Si la relación entre ambas frecuencias de muestreo se mantiene constante a través del tiempo, entonces se utiliza conversión sincrónica. Este es el caso típico del downsampling que me toca realizar al final del proceso demasterización de un CD, ya que cualquiera sea la frecuencia original de muestreo, voy a convertir a 44.1 KHz para quemar los CD masters. Si en cambio la relación no es conocida o puede variar a través del tiempo se utiliza conversión asincrónica. Este es el caso (cada vez más común) de múltiples fuentes de audio digitales, cada una con su propio reloj interno, que deben ser procesadas en forma simultánea (streaming de audio, reproductores de audio en red,compresores de audio, etc).

Finalmente, hay que recordar que una razón de peso en la decisión de adoptar frecuencias de muestreo de sólo 44.1 y 48 KHz en el comienzo de la era digital fue lo que conocemos como BitBudget, es decir el presupuesto de bits disponible. En un CD de audio, la información se almacena a razón de 10 MB por minuto aproximadamente: cuando el formato CD comenzó a ser de uso masivo, el costo por MB en los discos rígidos era entre 500 y 1000 veces mayor que ahora. Esto explica que a comienzos de la década pasada fuera absolutamente imposible pensar en frecuencias de muestreo que obligaran a consumir el doble o el cuádruple del espacio por cada minuto de música almacenada. Todavía me acuerdo del disco rígido de “ultra alta capacidad” que pagué a precio de oro y venía con... ¡1 GB! Lo llamábamos “El Giga” y era la estrella del estudio. Otros tiempos, por supuesto.

Como corolario de esta serie de apreciaciones, creo que la señal de alta frecuencia tiene una cierta influencia en la manera en que percibimos la música, pero hay que condicionar esta conclusión a determinados parámetros:

- Los instrumentos a grabar deben ser capaces de producir energía de alta frecuencia en valores medianamente significativos

- El entorno y las condiciones de grabación deben ser los apropiados para poder oír la diferencia, de lo contrario no hay ninguna posibilidad de detectar una mejora.

- Si el formato final será de menor resolución y es necesario hacer downsampling, hay que extremar los cuidados para que la degradación introducida en este proceso final no dé un resultado peor que el que se logra trabajando directamente en la frecuencia de muestreo más baja y sin downsampling.

- En cualquier caso, las diferencias serán siempre de orden muy sutil. Para muchos es despreciable, mientras que para otros tal sutileza es la esencia misma de la música.

Andrés Mayo es ingeniero de mastering y realizador de DVD musicales. Miembro fundador de Team 5.1, es reconocido en Argentina por sus trabajos de masterización en estéreo y surround. Es vicepresidente de A.E.S. Región América Latina.