Grabar a 44,1 o 48 kHz: ¿cuál es mejor y por qué?

- ¿Le importa al oído el mayor ancho de banda posible?

- ¿Le importa a los interfaces?

- Filtro ‘cero alias': No, gracias

- Échale la culpa al marketing

- Una solución de compromiso

- Cuánto mejora 48 respecto a 44,1

- ¿Y si sobrefiltramos nosotros?

- Los AD típicos: filtro fijo pese a fs variable

- Pero ¿qué velocidad elijo?

- Ojo con los conversores de frecuencia nativa fija

- Conclusión

A veces tener opciones es bueno, y a veces, como en esta del uso de 44,1 o 48 kHz como frecuencia de muestreo, sólo sirve para liar las cosas. Intentamos dar una opinión razonada sobre una cuestión que surge en algunos debates, pero bienvenidas tambíén tus impresiones y experiencias.

Los argumentos son extrapolables a otras parejas (como 88,2 y 96). Si lo que te interesa es saber qué razones pueden justificar el paso de las velocidades x1 (44,1 o 48) a las superiores (88,2; 96; 176,4; 192,...) encontrarás una buena lectura en este otro artículo.

¿Le importa al oído el mayor ancho de banda posible?

[Índice]Plantearse la elección entre 44,1 y 48 por una cuestión de que se percibe a oído el incremento de ancho de banda lo encuentro bastante ridículo. La diferencia en ancho de banda que permite el paso de una a otra es menor que 1 semitono con 46 cents. Es menos que 1/8 de octava. Para colmo en una región ya tan alta que nuestro oído no va a apreciar de forma significativa tan ínfimo incremento. Lo mismo puede decirse de 88,2 y 96, o de 176,4 y 192, etc. Siempre se trata de ese menos de 1,5 semitonos y en zona cada vez más alta.

No significa esto que no se oiga alguna forma de mejora, pero no está vinculada directamente a ese espacio de más que pueda llegar a ganarse en una zona apenas audible. Se trata de efectos secundarios de la digitalización. Así que pensemos si podría suponer algún beneficio para los sistemas Y veremos que un poco sí.

¿Le importa a los interfaces?

[Índice]El principal problema de la grabación digital es el aliasing, derivado de la incapacidad para representar adecuadamente señales que superen la mitad de la frecuencia de muestreo. Eso conlleva la necesidad de filtrar la señal analógica antes de la digitalización, es decir, imponer un límite máximo en las frecuencias registrables. Un filtrado que debe ser suficientemente selectivo para que las componentes que excedan el límite y se vean reflejadas por el aliasing ya vengan muy rebajadas en nivel (idealmente hayan desaparecido), pero a la vez respetando (dejando pasar sin filtrar) tanto recorrido del espectro audible como sea posible (es decir, haciendo que su frecuencia de corte sea cercana a los 20kHz). Son dos criterios claramente antagónicos.

En ningún filtro práctico encontraremos una pendiente ‘infinita’, o al menos no sin incurrir en otros problemas al tratar la señal. Como resultado siempre existirá una determinada caída de nivel progresiva (una pendiente, no un acantilado) a partir de la frecuencia de corte y podemos hablar de una ‘zona de transición’ entre la banda de paso y la banda ya suficientemente eliminada para no ser conflictiva.

Y ahí habría varias opciones respecto a cómo definir ese filtro.

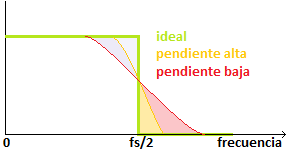

Filtro ‘cero alias': No, gracias

[Índice]Situando la transición para que al llegar a 20kHz haya un rechazo altísimo, y estar así seguros de que el alias no nos afecte de forma apreciable, estaremos afectando con una reducción de nivel en la parte alta de la banda audio, con lo que perdemos algo de presencia aguda/brillante.

¿Cómo de grave es ese recorte? Depende de la pendiente del filtro. Pero llegar a tener un rechazo de las componentes ‘fuera’ de la banda permisible tan alto como para que no degrade la calidad de la que hablan 16 o 24 bits de cuantificación es terriblemente exigente. Pensad que esas componentes deberán tener una energía bajísima para que no eleven un pedestal de ruido por cuantización que está en cifras tan bajas como -96 o -144 dB.

Las pendientes típicas varían mucho, pero pueden situarse en unas decenas de dBs por octava. Quizá rondando los 24 o 48 dB/oct, a veces mayores (especialmente con diseños híbridos analógico-digitales, como los conversores sigma-delta y semejantes, de ahí su popularidad). Pensad en 48dB/oct en el filtro: necesitaríamos comenzar la caída dos octavas antes del límite. Eso nos lleva a la la zona de 5000Hz., algo que nadie deseamos.

No es por tanto ese el tipo de diseño que se usa.

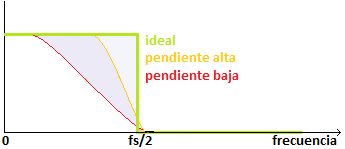

Échale la culpa al marketing

[Índice]El marketing presiona para ofrecer a la gente aquello que espera leer y no para enseñarles qué es lo que les viene mejor. Para ofrecer cifras ‘de 20Hz a 20kHz’, que son las que todos gustamos de encontrar en las especificaciones, el arranque de la banda de transición tiene que llevarse bien arriba:

No he querido ni pintar el ‘espejo’ de esas frecuencias demasiado altas. Pero dejan claro que sí o sí, hay que asumir que algo de aliasing tendremos. De hecho un alias máximo con este tipo de orientación en el diseño del filtro. Salvo que la selectividad del filtro, su pendiente, fuera abruptísima, esas transiciones una vez reflejadas hacia abajo van a extender la presencia de alias más que en ninguno de los otros casos.

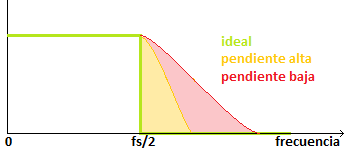

Una solución de compromiso

[Índice]La gente se echa para atrás en sus decisiones de compra cuando le dicen que el ancho de banda llega hasta por ejemplo 18kHz en vez de hasta 20kHz, quizá desconociendo que al final puede ser mejor limitarse un poco. Vale, está bien tener ancho de banda amplio, pero en la digitalización, de verdad, no pasa nada (y hasta salimos ganando por el menor aliasing) por decir adiós al extremo alto.

Sería posible situar en fs/2 un rechazo amplio, pero no exhaustivo. Eso repartiría el problema: menos recorte en agudos que en el 'cero alias', pero a cambio más presencia potencial de aliasing.

No olvidemos que las frecuencias superiores a fs/2 no existen en digital y aparecen ‘reflejadas’:

Alguna actuación de ese tipo, cortando a propósito algo de brillo, pero también admitiendo un cierto alias es una posible alternativa al compromiso que existe en el diseño del filtro. Realmente el extremo de los 20kHz no suele necesitarse, menos aún cuando para tenerlo lo vamos a acompañar de unas dosis altas de aliasing que se extiendan hacia frecuencias más bajas.

Con este tipo de diseño vemos confinados en la zona alta los problemas, tanto de pérdida de brillo, como de introducción de alias. Sencillamente aquí está repartido el compromiso de otra forma.

Cuánto mejora 48 respecto a 44,1

[Índice]¿Qué tipo de respuesta ofrecen nuestros interfaces? Para mi gusto, la presión por poder ofrecer cifras de ancho de banda que se extiendan de 20 a 20k es determinante y al final podemos tener un exceso de alias que no queda justificado por el posible beneficio de extendernos hasta esos 20k.

En ese escenario ¿mejora la cosa con 48 kHz frente a 44,1? Por tomar una referencia, con un filtrado de 48dB/oct, ese semitono y medio más de espacio (1/8 de octava) que nos aporta el uso de 48 frente a 44,1, conseguirá unos 6dB adicionales de rechazo. No es despreciable, ciertamente, pero también los podemos conseguir rebajando ese semitono y medio el corte al adquirir a 44,1, si lo que necesitamos es un producto final a 44,1.

Reflexión que podemos ampliar un poco más.

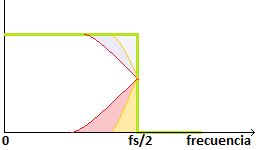

¿Y si sobrefiltramos nosotros?

[Índice]Podéis imaginar por dónde voy. No es nada descabellado pensar en, antes de vuestros conversores excelentísimos que prometen respuestas ultralineales de 20 a 20k forzar un filtrado que recorte un poco la parte alta, siempre que sea de buena calidad.

Quizá vaya siendo hora de que además de los clásicos ‘low cut’ que tantísimos sistema audio tienen, pidamos que haya unos ‘high cut’ analógicos en las entradas que nos permitan decidir sobre ese compromiso entre brillo y alias que es inevitable en cualquier digitalización.

Pero mientras ese día llega (no lo veo cercano en absoluto) igual podemos pensar en contar con algún filtro analógico que añadamos a nuestras entradas, al menos cuando capturemos señales muy generosas en energía en frecuencias altas.

La alternativa pasaría por grabarlas a velocidades superiores (88,2 o 96, etc.) con los inconvenientes clásicos de mayor espacio de almacenamiento y sobre todo un consumo de CPU que crece exponencialmente. Pero si sobra CPU y falta dinero para hardware, tampoco lo despreciéis. Y en ese caso, no olvidéis el consejo de Euridia en un tutorial reciente de no usar esas frecuencias altas para conservar la actividad de 20k a 40k. Es conveniente eliminar la señal en esa mitad alta, pese a que la frecuencia de muestreo parezca poderla asumir. Queremos ese espacio como un colchón donde dejar que se desarrolle el alias al procesar sin verse reflejado a la banda de 20-20k, sabedores de que podremos retirarlo.

Los AD típicos: filtro fijo pese a fs variable

[Índice]Alguna reflexión más. No tengo datos estadísticamente significativos al respecto, pero en los casos que sí conozco (y es razonable pensar que sea así con carácter general) los interfaces AD operan con un mismo filtro, tanto si el usuario escoge frecuencia de muestreo 44,1 como si usa 48. La frecuencia de corte de esos filtros no se cambia para adaptarse a la frecuencia de muestreo que hayamos elegido.

Enterarse de si nuestro interfaz usa filtrado diferenciado con 44,1 y con 48 no es tarea fácil porque no suelen decirlo las especificaciones (y poca gente se va a dedicar a probarlo). Si lo usa (un filtro un poco más cerrado con 44,1) no habría especial mejora en ir a 48. Si no lo usa (que es lo que suele pasar) dependemos de cómo de estricto sea el filtro. Si la pendiente es alta puede tener cierta utilidad ir a 48 en vez de a 44,1 (esos 6dB de rechazo adicional si era un filtro de 48dB/oct -que ya es un señor filtro-). Si la pendiente es baja, pasa a tener menor impacto la opción por uno u otro.

Las más de las veces, a día de hoy, las especificaciones sólo están contadas para una de las dos frecuencias (típicamente la de 48 porque sale mejor) y no tenemos información sobre el filtro, su frecuencia de corte ni su pendiente. Y aunque es posible hacer pruebas para averiguarlo, es laborioso.

En todo caso, nos puede quedar la idea de que sí: hay una cierta mejora en usar la velocidad 48 en vez de la 44,1 que es tanto mayor cuanto más abruptos sean los filtros antialias.

Pero ¿qué velocidad elijo?

[Índice]Pese a esa posible mejora al usar la velocidad alta de cada par, hay que tener una cuestión más en cuenta. Tras grabar a 48, si el formato final principal de nuestro producto va a ser a 44,1 se va a necesitar una conversión de frecuencia de muestreo al final. Esa conversión no deja de ser un nuevo proceso susceptible de incorporar sus propios problemas.

Lo ideal sería que probarais qué os ofrece mejor resultado a oído: partir de grabar a 48 y realizar al final una conversión a 44,1 o bien grabar directamente a 44,1. Hace algunos años, la recomendación más plausible era la de realizar la grabación a la frecuencia del proyecto final. Si iba a ir destinado a CD mejor grabar a 44,1 para evitar esa última conversión.

Pero a día de hoy:

- Casi siempre vamos a tener que salvar en varios formatos (44,1 para CD, 48 para DVD,…)

- Existen sistemas de conversión de frecuencia de muestreo de buena calidad

Así que la opción casi siempre pasa por grabar en la velocidad alta de cada par, por ser la que presumiblemente nos dará un pequeño margen de mejora, que no va a hundir una conversión final a otra frecuencia de muestreo.

Ojo con los conversores de frecuencia nativa fija

[Índice]Pero toda regla tiene su excepción. En la misma línea de argumento que el párrafo anterior, pensad que a veces los conversores ofrecen una velocidad ‘nativa’ de grabación que es fija y la opción de 44,1 o 48 se consigue porque el propio interfaz calcula a partir de las muestras tomadas a su velocidad nativa las que corresponderían a la otra. Eso es una conversión de frecuencia de muestreo en toda regla. En esos casos, mucho ojo.

Va a ser siempre preferible grabar a la velocidad nativa del hardware (a día de hoy casi siempre 48) y dejar para un momento posterior y final (ya sobre el máster) la conversión a la velocidad deseada.

Pensad que esa conversión de frecuencia de muestreo en el interfaz se está haciendo a tiempo real y para colmo posiblemente con una latencia baja. Tanto el ir a tiempo real como lo de la latencia baja implican que se está usando poco cómputo, o al menos un cómputo mucho menor que el que puede llegar a disfrutar una conversión de la frecuencia de muestreo a la que le demos más CPU y más tiempo. Y creed que esa conversión de 44,1 a 48 es algo exigente. Sólo una de cada 7 millones de muestras (7056000 para ser exactos, el mínimo común múltiplo de 44100 y 48000) es coincidente, todas las demás necesitan ser calculadas.

Esos 7 millones de muestras hablan de unos dos minutos y medio... y durante ese tiempo el ruido debido al intento de aproximar el valor verdadero crece y decrece en un ciclo que dura esos 150 segundos. Nuestras pruebas de calidad no pueden basarse de forma fiable en un fragmento que dure menos que eso. Yo evitaría a toda costa la conversión de frecuencia de muestreo ‘en caliente’. Esos errores y ruidos irían individualmente agregados a cada pista y se sumarían en el resultado final.

Mejor grabar cada pista a la velocidad nativa, realizar toda la mezcla, y sólo al final, y con un software específicamente orientado y preparado para esa conversión de frecuencia de muestreo, realizar el cambio a la velocidad final. Revisad las opciones de los procesos de conversión. Muchas veces están por defecto aplicando unos ajustes ‘medios’ pero tenéis otros ‘óptimos’ que podéis activar (con el coste de una mayor latencia y cómputo, pero perfectamente asumibles en una conversión final de fichero máster a 48 a fichero en 44,1).

Conclusión

[Índice]Visto lo visto, al menos espero haberos convencido de que es un engorro esto de que haya dos velocidades. No sirve para una gran mejora, y sí para dar la lata a menudo, obligando a conversiones de frecuencia de muestreo. Conviene, como siempre, echar un vistazo a las especificaciones de la tarjeta, y pensar sobre esa base, cuál es la mejor combinación que podemos aplicar.

En la práctica, a día de hoy y con hardware y software reciente, casi siempre pasará por registrar y procesar en la velocidad alta de cada par (48), y, sólo si es imprescindible por cuestión de formato final, convertir el máster último a la velocidad del soporte de distribución (como los 44,1 del CD) usando las opciones de mayor calidad disponibles.

La grabación y procesado en la velocidad alta del par conseguirán casi siempre una pequeña mejora, que podremos ampliar aún más si usamos un filtrado adicional antes de la entrada, reconociendo que a la postre, el extremo cercano a los 20kHz es en buena medida innecesario. La vía de las velocidades altas x2, x4, etc siempre está abierta para quien pueda permitírsela pese al consumo de CPU y almacenamiento que origina.