He visto este hilo por casualidad y que no terminó por resolverse.

Para los técnicos de sonido que no saben de video explico una cosa primero: un video por ejemplo a 24 fps, como su nombre indica reproduce 24 imágenes en un segundo, si es a 25 fps, pues 25.

Si yo reproduzco un video originalmente de 24 fps en 25, lo que ocurre es que falta un fotograma que hay que inventarse (interpolación), para que mantenga la coherencia con la pista de audio. Por otro lado si reproduzco un video originalmente de 25 fps a 24 fps, sobra un fotograma que deberia ser desechado.

¿Y como influye esto en el DAW? Supongamos el caso que el video a 25fps, y en el DAW se edita reproduciendolo a 24fps. Lo que ocurrirá es que dentro del DAW se esta editando de acuerdo a la reproducción ahi dentro, todo parecerá sincronizado dentro del DAW, por ejemplo añades un efecto de un crack al romper algo etc....y todo ello esta sincronizado a la imagen que estas visualizando. Pero cuando se vaya al editor video cuanto mas tiempo pase mas fotogramas que en el DAW han sido desplazados van repercutiendo y progresivamente se produce una desincronización que no será perceptible por el humano hasta que no lleve acumulado un numero suficiente que lo haga perceptible. Por este motivo no funciona lo que se comenta que 1 minuto es 1 minuto, porque en un editor de video cuando pones la pista de audio debajo, no es lo mismo que la pista de video este a 25 fps que a 24fps, ya que en un momento determinado el fotograma X tendrá el sonido con marca de tiempo Y de la pista de audio, y si hay mas fotogramas, el fotograma X-1 será ahora el que corresponda con la marca de tiempo de audio Y. Y por eso si importa el numero de fotogramas.

Si fuera una desincronizacion por un desplazamiento (offset), la desincronizacion sería lineal, pero cuando es acumulativa, cuanto mas tiempo mas se produce, eso tiene pinta que es porque hay un fallo de reproducción de fotogramas. Básicamente cada segundo que pase, hay un offset que es acumulativo por eso al final se notará más.

Para saber cual es el problema concreto que ocurre habría que verlo con los elementos en cuestión, ya que podrían ser varias cosas. Yo voy a dar una recomendación que almenos os va a cantar antes de empezar la mezcla y es la siguiente: si el editor os pasa el video con las marcas de tiempo incrustadas en el propio video, os va ayudar (tanto la marca en fotogramas como en tiempo). De esta manera al cargar el video podréis verificar si la marca de tiempo de video esta encajando con la de vuestro DAW, y sino encaja algo pasa (revisáis fps etc...). Podeís ir al final del video en algún corte de plano a negro o cambio de plano de un fotograma, y verificar que vuestra marca de tiempo que indica el DAW se corresponde con la que tiene el editor de video.

Profundizando más en 1 minuto de video y audio, es 1 minuto. Esto que dice el compañero es cierto, pero hay que aclarar una cosa, la cuestión es mas bien si ese minuto de video lo reproduces a una cantidad X de fps que ocurre, y aquí esta la cuestión, llevémosla al extremo.

Hoy día esta muy de moda hacer un slowmotion con los móviles modernos, pues bien, si yo grabo 1 minuto de video a 120fps y lo reproduzco a 24fps tengo un video que se mueve muy lento. ¿Que ocurre si yo edito en un DAW este video para agregarle sonido o efectos?. Si en dos proyectos diferentes uno reproduciendo a 120fps y otro a 24fps, pues los efectos de audio van a estar sincronizados de acuerdo al video que yo estoy viendo. Ahora exporto los dos trabajos y los llevo de nuevo al editor de video, lo que va a ocurrir es que uno va a ir acorde al video y el otro no. Lógicamente porque cada editor de sonido ha sincronizado su trabajo acorde a lo que veía en el video, pero los dos no estaban viendo lo mismo porque no estaba reproducido a la misma velocidad.

Un proyecto va a tener una duración mayor que el otro. Al usar una velocidad de fotogramas con tanta diferencia. La diferencia de tiempo se vuelve totalmente clara y perceptible, por eso he puesto este ejemplo. Imaginad el mismo ejemplo pero reproduciendo a 24fps y otro a 23,976fps, o bien uno a 25 fps y otro a 24fps, lo que va a ocurrir es que hasta que no ha pasado tiempo suficiente como para que vayan acumulandose los suficientes fotogramas que hagan perceptible al humano esa desincronización, no será perceptible.

Esto como anécdota lo veréis en las películas antiguas de disney, donde se grababan a menos de 24 fps y daba una sensación de aceleración (justo al contrario) porque se reproducian a cerca de 24fps (mas de lo grabado). No es lo mismo grabar las voces por ejemplo de estas peliculas visualizando la película a 18 fps que a 24fps, por el motivo anterior comentado.

Ejemplo practico:

Antes mencionar algo, sobre los 24fps, algunos editores de video indican 24fps, cuando realmente estan trabajando a 23,976fps, lo normal es que en las propiedades internas del video están indicadas, aunque esto es algo que el editor de video os debería indicar de forma exacta.

Tengo un video a 23,976fps que voy a editar para agregar SFX y lo reproduzco a 24fps. Le he incluido la marca de tiempo procedente del editor de video medida en HH:MM:SS:Frames.

Recordar que la marca de tiempo en el DAW segundo 1 (00:00:01,000), corresponde en el video a la marca (00:00:00:23), por tanto el segundo 10 en el DAW (00:00:10,000), corresponde en el video a la marca (00:00:09:23), y así sucesivamente.

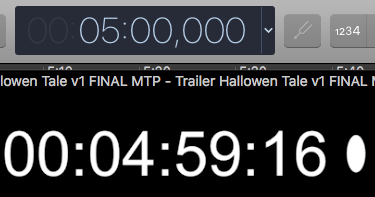

Según la lógica es que si salto a la marca de tiempo del DAW minuto 5 (00:05:00,000) debería corresponder al video a la marca (00:04:59:23), pero como se observa en la captura c00.png

indica (00:04:59:16) ¿QUE HA OCURRIDO???, no debería ocurrir esto si 5 minutos son 5 minutos.

Veamoslo:

24 fps - 23,976 fps = 0,024 fotogramas de diferencia

1 fps / 0,024 fotogramas = 41,6 segundos

Este calculo, me esta indicando que a partir del segundo 41,6 ese fotograma de diferencia acumulado se hará digamos efectivo y comenzará a desincronizar el video con el audio.

[Adjunto imágenes para verlo visualmente] [Desde la imagen c01 a c07]

Indico los segundos segun DAW:

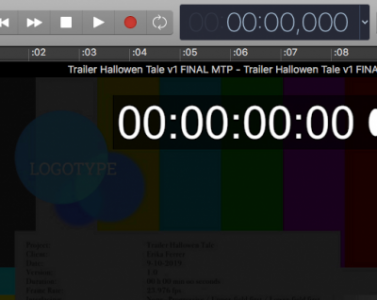

segundo 0:

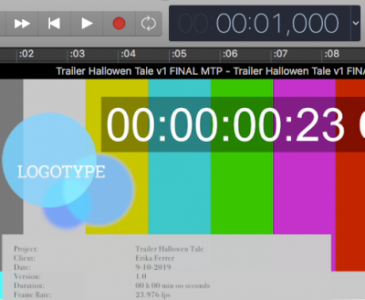

segundo 1:

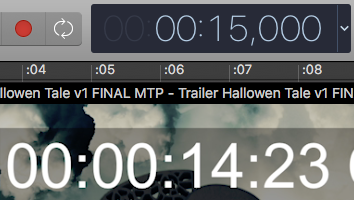

segundo 15:

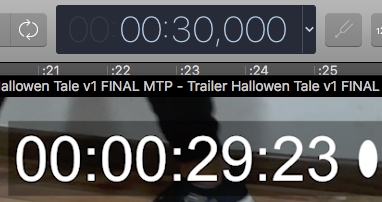

segundo 30:

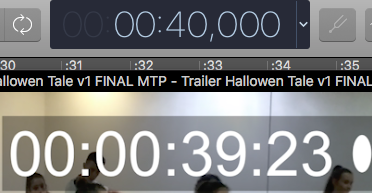

segundo 40:

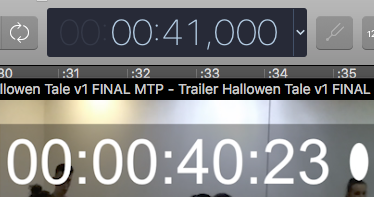

segundo 41:

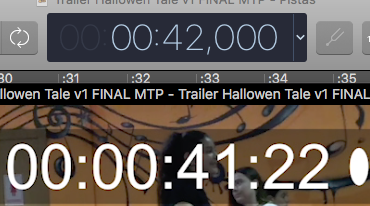

segundo 42:

Como se ve en las capturas, inicialmente cada segundo aparece sincronizado, ese decir dentro del DAW a cada segundo de reproducción le corresponden los fotogramas del 0 a 23 del segundo en cuestión de video. Pero al pasar del segundo 41 al 42, se produce una desincronización, es decir el fotograma de video 23 del segundo 41, se va reproducir en el segundo 42 del DAW en una posición diferente de tiempo. Si este desplazamiento, lo hacemos acumulativo en el tiempo llegará un momento que todo estará movido. Pero para mi ahora mismo como editor de sonido, si no veo esta marca de tiempo, colocaré los sonidos y efectos de acuerdo a lo que estoy viendo, cuando exporte el bounce final y lo lleve de nuevo al editor, entonces ese desplazamiento se hará visible y audible.

indica (00:04:59:16) ¿QUE HA OCURRIDO???, no debería ocurrir esto si 5 minutos son 5 minutos.

indica (00:04:59:16) ¿QUE HA OCURRIDO???, no debería ocurrir esto si 5 minutos son 5 minutos.